ChatGPT Version 5

Die Neuigkeiten (ab Version 5.1)

Erscheinungsbild: Der Chatbot präsentiert sich sprachlich glatter, in der Bewerbung als wärmer bezeichnet, mit natürlicherem Sprachstil und gefälliger für die Benutzerschaft. icht unkritische, denn wenn Sprachmodelle darauf trainiert werden, warmherzig und einfühlsam zu sein, werden sie weniger zuverlässig und „kriecherischer“, behauptet eine Studie der University Oxfort vom Juli 2025. Zuviel Schmeichelei untergrabe die Zuverlässigkeit, weisen die Autoren der Studie nach (Fehlerrate getestet bei sicherheitskritischen Aufgaben zwischen 10 und 30 Prozent erhöht).

Zwei Modi: Man kann wählen zwischen Instant für schnelle, Thinking für gründlichere Antworten, und Auto, wenn man dem Chatbot die Entscheidung überlässt. Im Innenleben des Sprachmodells von ChatGPT wird zwar die Technik des Reasoning verwendet, doch wenn man die Aufteilung der Benutzereingabe in einzelne Aufgaben des sog. Nachdenkens sehen will, muss man zum chinesischen DeepSeek greifen.

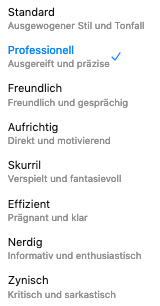

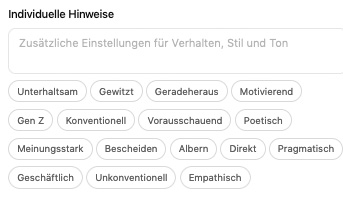

Neue Sprachstile: Über die Einstellungen in ihrem Account kann nun jede Person eine zu ihr passenden Sprachton wählen. Die Auswahl habe keinen Einfluss auf die Inhalte, sondern soll nur die Stimme bei Sprachwiedergabe betreffen, „lebensecht ... mit individuellem, unverwechselbaren Tonfall und Charakter“, wie es in der Erklärung heißt. Man kann einige Zeit damit verbringen, um das Gefälligste für sich herauszufinden. Die Untertitel bei den Einstellungsmöglichkeiten geben allerdings Rätsel auf: Was unterscheidet ausgereifte und präzise Antworten von direkten und motivierenden? Was ist die Differenz zwischen professionell und aufrichtig? Sind enthusiastische Wahrheiten noch informativ? Die Benutzerinnen und Benutzer sollen es wohl selber herausfinden.

Neue Sprachstile: Über die Einstellungen in ihrem Account kann nun jede Person eine zu ihr passenden Sprachton wählen. Die Auswahl habe keinen Einfluss auf die Inhalte, sondern soll nur die Stimme bei Sprachwiedergabe betreffen, „lebensecht ... mit individuellem, unverwechselbaren Tonfall und Charakter“, wie es in der Erklärung heißt. Man kann einige Zeit damit verbringen, um das Gefälligste für sich herauszufinden. Die Untertitel bei den Einstellungsmöglichkeiten geben allerdings Rätsel auf: Was unterscheidet ausgereifte und präzise Antworten von direkten und motivierenden? Was ist die Differenz zwischen professionell und aufrichtig? Sind enthusiastische Wahrheiten noch informativ? Die Benutzerinnen und Benutzer sollen es wohl selber herausfinden.

Personalisierung: Weitere Einstellunsmöglichkeiten werden angeboten, erstmals nur für die zahlende Kundschaft, doch sicher bald auch für alle. Man wolle sensibel auf die Kunden reagieren, die einen zu kühlen Ton der bisherigen Version bemängelt haben.

Auch möchte man den Wunsch vieler Benutzerinnen und Benutzer besser respektieren, die sich eine engere Beziehung zu ihrem Chatbot wünschen: Dein Chatbot, dein Freund und Helfer.

Auch möchte man den Wunsch vieler Benutzerinnen und Benutzer besser respektieren, die sich eine engere Beziehung zu ihrem Chatbot wünschen: Dein Chatbot, dein Freund und Helfer.

Sollte ich den Chatbot als Hilfe beim Texten verwenden und mich gerade nicht in Form für witzige Formulierungen fühlen, kann ich diese Nachdenk-Anstrengung getrost an meinen Chatbot delegieren. Dann kann ich mir auch sparen, darüber nachzudenken, was dieser Schonbetrieb auf Dauer mit meinem Gehirn macht. Pädagogen, von zahlreichen wissenschaftlichen Studien unterstützt, warnen vor der Langzeitwirkung. Der Weg wird vorgezeichnet: Vom behüteten Denken zum betreuten Leben.

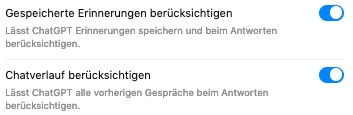

Chatverläufe: Man kann - zumindest bei der Bezahlversion - die Berücksichtigung von seinen vergangenen Chatverläufen ein- und ausschalten. Der Default ist natürlich eingeschaltet, wie bei allen auf das Datensammeln versessenen Anbietern. Die Folge ist, dass für die Erzeugung zukünftiger Antworten auch die Inhalte der bisherigen Chatverläufe berücksichtigt, d.h. als erweitertes Kontextfenster behandelt werden.

Chatverläufe: Man kann - zumindest bei der Bezahlversion - die Berücksichtigung von seinen vergangenen Chatverläufen ein- und ausschalten. Der Default ist natürlich eingeschaltet, wie bei allen auf das Datensammeln versessenen Anbietern. Die Folge ist, dass für die Erzeugung zukünftiger Antworten auch die Inhalte der bisherigen Chatverläufe berücksichtigt, d.h. als erweitertes Kontextfenster behandelt werden.

Ebenfalls kann man seine eigenen Chatverläufe für das Training des Chatbots freigeben, in der Voreinstellung auch aktiviert. Damit hat OpenAI dann die Erlaubnis, diese Daten nach eigenem Ermessen in künftigen Trainings für den Chatbot zu verwenden. Ich darf mir nun überlegen, ob ich als gute Tat für die Menschheit meine klugen Fragestellungen und elaborierten Antworten des Systems zum Training anbiete. Für echte Fieslinge ist das Tor aber auch für kleine Sabotageakte geöffnet, wenn ich gezielt und bewusst lauter unsinnige Unterhaltungen mit dem Chatbot führe. Natürlich darf ich auch mein gefühlsmäßiges Innenleben in epischer Breite zur Verfügung stellen.

Eine kurze Bemerkung noch zum Datenschutz: Die Voreinstellungen des Chatbots verraten nicht gerade eine ausgeprägte Vorliebe des Anbieters für privacy by default.

Erste Eindrücke

Die stärker in den Vordergrund genommene Emotionalität verdient eine genauere Betrachtung. Zur Erinnerung: Die Sprachmodelle hinter den Chatbots sind eigentlich dafür gemacht, auf eine Anforderung die bestwahrscheinliche Antwort zu finden. Nun heißt es offensichtlich - zumindest für ChatGPT - zurückstecken zu Gunsten von mehr Unterhaltungswert, Priorität für Stimmungslage und user feeling.

Die emotionale Färbung soll Echtheit suggerieren. Man sollte nicht vergessen: Die KI-Sprachmodelle können nichts fühlen, sie verarbeiten nur digitalen Input, haben keine Empfindungen und folglich auch keine Gefühle. Sie können Emotionalität nur simulieren.

Benutzerinnen und Benutzer können allerdings diese Simulation für Echtheit halten, je stärker, desto bessser die Simulationen dem Schein der Wirklichkeit näher kommen. Mit Formen künstlicher Empathie wird ein neues Feld betreten, das nicht im Visier traditioneller Gefährdungsanalysen liegt.

Emotionen tun sich schwer mit evidenz-basierter Beschreibung. Das macht sie geeigneter für Manipulationen jedweder Art. Eine allein über Emotionen begründete Meinung oder innere Einstellung erweist sich oft als immun gegen kognitive Überprüfung. Die Sprachmodelle hinter den Chatbots arbeiten immer noch nach der Devise „Was ist die wahrscheinlichste zutreffende Antwort auf ein Benutzer-Input“. Doch das so gefundene Ergebnis wird zunehmend durch Algorithmen überlagert, die für eine Veränderung des ursprünglichen Ergebnisses sorgen. Schon die Veränderung des Sprachstils ist nicht frei von Manipulation. Kritischer wird die Angelegenheit, wenn sich die Algorithmen auch um die Inhalte kümmern. Da gehört die Verformung im Sinne von political correctness noch zu den harmlosesten Varianten (Mehr dazu in dem Dokument Chatbots - Verlust der Unschuld).

Gutmeinende Beobachter konstatieren OpenAI, ihrem Chatbot „mehr Charakter“ verliehen zu haben und Benutzerbedürfnisse bessser zu befriedigen. Doch OpenAI muss sich den Vorwurf professioneller Testpersonen (Reddit) gefallen lassen, eher Kosmetik als präzisere Leistung zu bringen.

Die Erfahrung wird zeigen, was von dem proklamierten Fortschritt zu halten ist. Wir bleiben dran.