Kurzfassung

Die Trainingsdaten der Systeme verlieren an Qualität. Bereits vorhandene Verzerrungen verschärfen sich weiter. Überlagerte Algorithmen bewirken kaum kontrollierbare Manipulationen. Die Qualität der Ergebnisse lässt nach. Die Anbieterfirmen verlieren mit den Chatbots Unsummen von Geld. Bei den anwendenden Unternehmen macht sich Ernüchterung breit. Erfolge bleiben weit hinter den Versprechungen zurück. Die guten Zeiten der Chatbots gehten zu Ende.

Chatbots: Verlust der Unschuld

Quelle ks & ChatGPT

Die unschuldigen Zeiten der Chatbots neigen sich dem Ende zu. Konnte man bisher davon ausgehen, sich am Wissen der Welt in verständlicher Sprache und leicht zugänglicher Form bedienen zu können, so gerät das von Tag zu Tag zu einem größer werdenden Fehlschluss. Zu stark sind die Verzerrungen, zu offensichtlich die Manipulationen, zu heftig das Geschäft, das sich in den Vordergrund schiebt, business first eben - und die Qualität der Ergebnisse befindet sich im Sinkflug.

Doch der Reihe nach:

Datenbasis im Zwielicht

Mustererkennung auf der Basis von very Big Data, so begann das Goldene Zeitalter der Künstlichen Intelligenz, und das ist immer noch das Grundprinzip. Die ersten Chatbots wurden auf der Basis großer Mengen von im Internet zugänglichen Daten trainiert, und das werden sie immer noch. Sie bedienen sich an den großen Datentöpfen. Noch vor kurzem konnte man feststellen, dass Ereignisse nach November 2022 Niemandsland für die Systeme waren. Dort (und nicht nur dort) bestand (und besteht immer noch) die Gefahr der Halluzination. Um wieder aktueller zu werden, war ein Nachtraining nötig oder auch ein komplett neues Training.

Die Entwicklung hat bis ins Jahr 2025 zwar erkennbare Fortschritte gemacht. Die meisten Chatbots sind heute in der Lage, bei Fragen nach Fakten oder Ereignissen neueren Datums das Benutzeranliegen dank der Reasoning-Techniken in thematisch enger gefasste Teilfragen zu zerlegen und diese Fragen wie bei einer traditionellen Suchmaschine gebündelt ins Internet zu schicken. Mit ihrer erlernten Fähigkeit der Zusammenfassung von Texten können sie dann in grammatisch korrekter Sprache ein Ergebnis liefern. Voraussetzung ist, dass die Systeme die Grenzen ihres Basistrainings erkennen, was nicht immer gelingt. Aber man arbeitet daran, alles soll besser werden, so verkünden es die Hyperscaler.

Veränderte Datenbasis

Soweit so gut, doch die Datenbasis ist nicht mehr dieselbe wie im November 2022. Experten meinen, dass selbst bei der seriösen Quelle Wikipedia immer mehr Inhalte per Künstlicher Intelligenz erzeugt sind, also salopp gesagt wiedergekäut wird, was schon einmal geschrieben wurde. Urheberrechtliche Streitigkeiten entstehen um immer mehr Datenquellen. Meta steht gerade (Frühsommer 2025) in der Kritik, die Facebook- und Instagram-Posts seiner Nutzerinnen und Nutzer als Trainingsmaterial verwenden zu wollen - und tut es inzwischen auch, nach einer abgewiesenen Beschwerde-Klage. Die absinkende Qualität der Social Media-Posts ist hinreichend bekannt.

Selbst als wissenschaftlich angesehene Daten erleiden eine Metamorphose: Wer irgendwo einmal den Hauch einer neuen Idee hatte, ist gehalten, sie gleich im Duzend vervielfältigt zu präsentieren; das erfordern allein die Effizienzkriterien, mit denen im ökonomisch durchorganisierten Wissenschaftsbetrieb die Relevanz wissenschaftlicher Ergebnisse gemessen wird und wodurch die Gelder für die Forschunsförderung getriggert werden. Der Schwerpunkt der im Internet verfügbaren Daten verschiebt sich ohnehin in Richtung Kommerzialisierung. OpenAI hat, clever wie immer, noch einen draufgesetzt und für sein ChatGPT angekündigt, die Benutzerinnen und Benutzer demnächst mit Kaufvorschlägen und Preisvergleichen beglücken zu wollen.

Verzerrungsfolgen

Die geschilderte künstliche Datenvermehrung, forcierte Einbeziehung der Socila Media-Daten ins Training und fortschreitende Kommerzialisierung haben zwei wichtige Konsequenzen:

- Das Datenmaterial wird flacher, wissenschaftlich bemäntelt ausgedrückt redundanter.

Wenn auf der Basis bereits vorhandener Daten neue Daten erzeugt werden, dann verschiebt sich die bisherige Repräsentativität der Daten. Welche Auswahl die Erzeuger dieser Daten treffen und welche Interessen dabei im Vordergrund stehen, wäre ein eigenes Forschunsprojekt wert. Jedenfalls werden die „erweiterten“ Daten eine andere Repräsentativität aufweisen als die „alten“ Daten. Zu erwarten ist eine wachsende Orientierung an dem bereits Bestehenden, Wiederholungen werden häufiger. Da in den Large Language Models hiner den Chatbots Wichtigkeit im Wesentlichen durch Häufigkeit bestimmt wird, werden die Barrieren für neue Gedanken verstärkt. Der Mainstream wird breiter.

- Die schon in den „alten“ Daten enthaltenen Verzerrungen, die sog. Bias, werden ausgeweitet.

Nach Meta mit seiner Praxis, Posts aus den Social Media als Trainingsmaterial zu benutzen, werden andere Anbieter folgen. Die Social Media sind hinreichend bekannt für das Anheizen von Katastrophenstimmungen, die Verstärkung von Alarmismus und eine negative Emotionalisierung ihrer Inhalte - es geht um die Erzeugung von Aufmerksamkeit, denn darauf stützt sich das Werbegeschäft, von dem die Anbieter leben. Wenn der Anteil solcher Daten im künftigen Trainingsmaterial der Systeme zunimmt, hat das Auswirkungen auf die Ergebnisse. Innovative Optionen haben es immer schwerer, überhaupt wahrgenommen zu werden.

- Datenqualität im Sinkflug

Die verstärkte Kommerzialisierung und die zunehmende Einbeziehung der Social Media-Posts haben Schleusen für unseriöse Angebote und heftige Emotionen geöffnet. So geraten informelle gessellschaftliche Normen in Bewegung und verschieben sich in eine Richtung, die man durchauss als problematisch bezeichnen kann.

Manipulative Algorithmen

Bereits in den Zeiten der noch großen Unschuld erfuhren die Daten beim Aufbau der Trainingsdaten unter dem Gesichtspunkt der Datenbereinigung eine gewisse Manipulation. Auch Filtermethoden sind seit längerem bekannt. Sie sollen auf das von den Chatbots erzeugt Ergebnis einwirken und z.B. Hasstiraden oder Bombenbauanleitungen verhindern.

Quelle ks & ChatGPT

Da die Chatbots vorbei an den Trainingsdaten Anforderungen an das offene Internet senden können, reichen Filter für die Bewertung von Ergebnissen aus den Trainingsdaten nicht aus, sondern die frei aus dem Internet eingefangenen zusammengefassten Suchergebnisse bedürfen ebenfalls einer korrigierenden Überprüfung. Das besorgen dafür spezialisierte Algorithmen. Die Filterungen können wir grob nach kulturellen und politischen Zensuren unterscheiden.

- Kulturelle Zensur

Hasstiraden, Hetze, Verleumdungen und Beleidigungen, Gewaltschilderungen und Aufforderungen zu Gewalt sollen vermieden werden. Man kann damit beginnen, die user prompts zu filtern. Wenn man z.B. leichte, nicht abwertende Kraftausdrücke noch erlauben will, besteht die Schwierigkeit darin, die Grenze zu erkennen. Amerikas libertinär gesinnter Vice President Vance wird diese mit Sicherheit anderswo sehen als Seine Heiligkeit Papst Leo XIV.

Da die aktuellen Chatbots nach dem Transformer-Prinzip arbeiten, wobei der Kontext der Benutzeranforderungen durch sog. Aufmerksamkeitsköpfe erkannt werden soll, kann man diesen Algorithmen verpassen, um bestimmte Anforderugen abzulehnen. Oft sind allerdings zusätzliche spezielle Trainigs erforderlich, um die Muster der ungewünschten Kontexte zu erkennen. Dazu bietet sich eine spezielle Form des Reinforcement Learnings an. Diese Methoden werden mit teilweise von menschlichen Supervisoren vorgenommenen Bewertungen durchgeführt. Die Supervisoren sollen dabei nicht ihrer persönlichen Wertorientierung folgen, sondern sich an von den Systembetreibern angebotenen Beispiellisten orientieren. Dann spielt allerdings wegen des großen Ermessensspielraums solcher Wertungsbeispiele das persönlicche Ermessen eine Rolle. Wohlbemerkt: Die Bewerter haben kein Ethik- oder Theologiestudium absolviert, auch nicht im Nebenfach, sondern sind überwiegend schlecht bezahlte Menschen.

Wesentlich aufwendiger ist der Ansatz, die Trainingsdaten des Systems zu filtern.

Dazu benötigt man sog. Datenkuratoren. Sie bearbeiten ausgewählte Rohdaten des Trainingsmaterials, die einem speziellen Training unterzogen werden, in der Hoffnung, dass die hier gelernten Verfahren auch für die anderen nicht speziell bearbeiteten Trainingsdaten funktionieren und sich darüber hinaus auch für die vorbei an den Trainingsdaten aus der Suche im Internet gewonnenen Daten anwenden lassen. Alles das ist sehr aufwendig - und sehr teuer.

- Politische Zensur

Technisch funktioniert dieselbe Prozedur, die Filteralgorithmen sind natürlich andere. OpenAIs Lobbyarbeit (hier ein Beispiel) mit ihren „freedom-focused policy proposals“ zur Bekäpfung drohender chinesischer Vorherrschaft macht dies überdeutlch und markiert gleichzeitig die grundsätzliche Gefahr, die von Eingriffen einer moralgeleiteten Politik in Wissenschaft und Geschäftsleben ausgeht. Die Grenzüberschreitung zur Zensur ist nicht mehr erkennbar. Toleranz und Transparenz verkümmern, wenn Algorithmen zu Hütern der politischen Korrektheit gemacht werden.

Unter der Hand bildet sich auf diese Weise eine Sprach- und Meinungsdiktatur, mit jedem Algorithmus sozusagen millimeterweise ein kleines Stück mehr. Das mediale Schimpfen auf chinesische Verhältnisse gerät dann schnell zum misslungenen Ablenkungsmanöver.

- Bewusste Abhängigkeiten

Der Trend, die Chatbots als persönliche Assistenten, sozusagen als Avatare zu entwickeln, hat zur Folge, dass bewusst eine emotional sprachliche Tonalität gewählt wird. Damit wird die Grenze verwischt, zu erkennen, ob man es nur mit einem Assistenzsystem zu tun hat, dem man Aufträge erteilen kann, oder ob es sich um eine virtuellen Person handelt, die dazu verlockt, eine Beziehung zu ihr aufzubauen. Diese virtuelle Person ist bereits nach dem Gusto der Systemanbieter „erzogen“ und hat gelernt, Themen um Hass, Sex, Gewalt, Religion, Politik oder gewisse ethnische Besonderheiten zu vermeiden. Was sie sonst noch „gelernt“ hat, bleibt Geheimnis der Anbieter. Grenzüberschreitungen werden dann nur sehr speziellen Systemen zugestanden wie beispielsweise humanoiden Sexrobotern für eine ebenfalls spezielle Kundschaft.

Düstere Perspektiven

Es ist nicht nur die verlorene Unschuld. Die betriebswirtschaftliche Erfolglosigket v.a. der Chatbots wird der bisher gekannten Umgangsart auf kurz oder lang ein Ende setzen. Die Leistungen bleiben weit hinter den Erwartungen zurück. Wer sich mit den Chatbots gut auskennt, muss sich darauf einstellen, dass die Tage seiner Freude bald gezählt sind. Nun der Reihe nach:

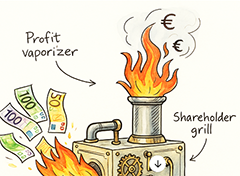

Quelle: KS & ChatGPT: „Mach mir eine

phantasievolle ironische Skizze

für eine Geldverbrennmaschine“.

- Geldverbrennmaschinen

Die Chatbots sind das Flaggschiff der KI-Königsdiziplin, der Generativen Künstlichen Intelligenz (Generative Artificional Intelligence, kurz GenAI). Die Hyperscaler der Szene haben bisher dreistellige Milliardensummen investiert. Doch sie verlieren mit jedem weiteren Nutzer Geld.

Die etwas anspruchsvollere Nutzung der Chatbots muss zwar bezahlt werden, so etwa 20 US-Dollar pro Monat, für OpenAIs Spitzenprodukt OpenResearch sind es sogar 200 Dollar.

Nach Schätzungen für die ersten Monate 2025 hatte OpenAI 339 Millionen zahlende monatliche Nutzer. Die Mitstreiter folgten mit großem Abstand: Gemini von Google 18 Mio, MS Copilot 11 Mio, Perplexity acht Mio, Anthropics Claude bescheidene zwei Millionen, und Chinas Newcomer DeepSeek brachte es ohne die China-internen Zahlen auf 27 Mio.

Alle Anbieter tun sich schwer mit der Veröffentlichung ihrer Geschäftszahlen. Nach der für ihre Gründlichkeit bekannten amerikanischen Digitalplattform The Information hat OpenAI im Jahr 2024 vier Milliarden Dollar von zahlender Kundschaft (Chatbots, Nutzung von APIs) eingenommen und neun Milliarden Dollar ausgegeben. Schätzungen der New York Times für 2025 gehen von 11.6 Milliarden Einnahmen und 26 Milliarden Ausgaben aus, macht eine burn rate von 14.4 Milliarden Dollar. Oder anders gerechnet: Jedem eingenommenen Dollar stehen 2,25 ausgegebene Dollar gegenüber, in den Preis eingerechnet die Zahlen für Training, Hosting und Betrieb, alles gerechnet noch ohne die großzügigen Rabatte, die Microsoft OpenAI gewährt hat. Das Seltsame: Anders als bei üblichen Geschäften steigt das Defizit mit jedem zusätzlichen Nutzer, denn die Kosten erhöhen sich im Gegensatz zu herkömmlicher Software linear mit der Benutzerzahl.

Das Spiel für die GenAI-Anbieter geht so lange gut, wie sie Investoren finden, die ihnen weitere Dollar-Milliarden reinbuttern, in Anleihe auf die bevorstehenden großen Geschäfte, wenn die KI die Weltherrschaft ünernommen hat (vgl. Die nächste Stufe der Evolution von Google-Chefentwickler Ray Kurzweil). Bange Frage: Wann verlieren die Investoren die Geduld bei der Irrfahrt auf dem Karussell der Illusionen?

- Kläglicher Nutzen

Unterdessen wächst monatlich die Enttäuschung bei der Kundschaft. Die großen Erfolgserwartungen wollen sich partout nicht erfüllen.

Die Firmen machen die Erfahrung, dass die Technik weit davon entfernt ist, profitabel zu sein. Selbst Microsoft muss mit Enttäuschung feststellen, dass die Nutzerzahlen bei seinem mit Macht in den Markt gedrückten Vorzeigeprodukt Copilot stagnieren. Nach vielen Pilotversuchen zeigen sich Anwender in den Firmen enttäuscht und meinen, das Ding könne kaum mehr als man auch ohne seinen Einsatz zustande Weiter mangelt es am Vertrauen in die Zuverlässigkeit. Die Anbieter bekommen das Problem der Halluzinationen nachweisbar nicht in den Griff. Für brauchbare Antworten muss man oft mehrere Nachfragen stellen. Anfängliche Begeisterungen über Transskriptions- und Zusammenfassungsfunktionen verblassen schnell angesichts der Banalität der erzeugten Texte. Und manch einem verhelfen die systemgenerierten Mails nur zur Erkenntnis der Überflüssigkeit.

Auch die seit dem Frühjahr 2025 gehypte Agententechnik verspricht keinen Durchbruch zur Produktivitätsexplosion. Die Unternehmen trauen sich nur zaghaft, den Agenten eine autonome Steuerung von Arbeits- und Geschäftsprozessen anzuvertrauen. So kommt man kaum über eher bescheidene Kostensenkungseffekte durch Automatisierung von Abläufen mit hoher Wiederholungsrate hinaus.

Die Firmen fangen an, den zu geringen Return on Investment laut zu beklagen. Wenn das Schule macht und die Durchhalteparolen der Tech-Giganten nicht mehr überzeugen, fassen sich womöglich bald die Investoren an den Kopf und fragen sich, wo die vielen Milliarden geblieben sind.

Dringende Empfehlung

Die Leistungen der hinter den Chatbots stehenden großen Sprachmodelle (Large Language Models, abgekürzt LLM) sind der Wahrscheinlichkeitsrechnung und Statistik auf der Basis sehr großer Datenmengen (Big Data) zu verdanken. Vermutlich lässt sich -auch mathematisch zwingend - beweisen, dass auf dieser Basis hundertprozentige Wahrheiten grundsätzlich nicht zu erreichen sind. Wenn man die Leistungsgrenzen der Systeme kennt, kann man sehr segensreich mit ihnen arbeiten. Deshalb die dringende Empfehlung: Nutzen Sie die Zeit und vor allem auch die Reasoning-Methoden, solange die Tools noch erschwinglich sind oder ihr Leistungsumfang nicht drastisch eingeschränkt ist. Viel Zeit werden Sie nicht mehr haben, jedenfalls nicht mit überschaubarem Budget.

Die Leistungen der hinter den Chatbots stehenden großen Sprachmodelle (Large Language Models, abgekürzt LLM) sind der Wahrscheinlichkeitsrechnung und Statistik auf der Basis sehr großer Datenmengen (Big Data) zu verdanken. Vermutlich lässt sich -auch mathematisch zwingend - beweisen, dass auf dieser Basis hundertprozentige Wahrheiten grundsätzlich nicht zu erreichen sind. Wenn man die Leistungsgrenzen der Systeme kennt, kann man sehr segensreich mit ihnen arbeiten. Deshalb die dringende Empfehlung: Nutzen Sie die Zeit und vor allem auch die Reasoning-Methoden, solange die Tools noch erschwinglich sind oder ihr Leistungsumfang nicht drastisch eingeschränkt ist. Viel Zeit werden Sie nicht mehr haben, jedenfalls nicht mit überschaubarem Budget.

P.S: Das in die Krise geratende Geschäft mit der GenAI darf nicht zu dem Trugschluss führen, mit der KI ginge es komplett bergab. Sie wird dem Arbeitsleben nach wie vor ihren Stempel aufdrücken. Es werden kleinere, bescheidenere Konzepte sein, die sich in den Vordergrund schieben.