Verfrühtes Lob

Der Verordnungsentwurf der Europäischen Kommission zur Künstlichen Intelligenz

Die EU-Kommission rühmt sich, den allerersten Rechtsrahmen für KI vorzuschlagen, der die Risiken der KI adressieren und Europa als eine führende Rolle weltweit positionieren soll. Sie klopft sich selber auf die Schultern mit der Behauptung, die Akzeptanz, die Investitionen und die Innovation im Bereich der KI in der gesamten EU zu fördern. Lohnt sich, genauer hinzuschauen.

Wie wir von Brüssel gewohnt sind, wird das Thema mit Verbotsregelungen angegangen. So will man „gezielt durch KI-Anwendungen geschaffene Risiken“ regulieren, allerdings ohne diese – abgesehen von einem allgemeinen Hinweis auf die Halluzinationsgefahr der ChatBots und der Ankündigung einer Liste von Anwendungen mit hohem Risiko (die maschinelle Übersetzung des englischen EU-Textes ist übrigens grottenschlecht) – konkreter zu benennen. Etwas präziser wird es dann bei den Verboten:

- Festlegung spezifischer Verpflichtungen für KI-Nutzer und Anbieter von Hochrisikoanwendungen;

- Verpflichtung der Anwender zu einer Konformitätsbewertung, bevor das KI-System in Betrieb genommen oder in Verkehr gebracht wird,

- die auch durchgesetzt werden soll, nachdem ein solches KI-System in Verkehr gebracht wurde und

- Einführung einer Governance-Struktur auf europäischer und nationaler Ebene.

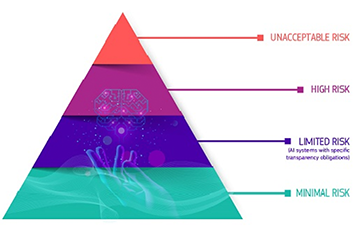

Risikostufen

Risikostufen

Die Technikangebote sollen in vier Risikostufen eingeteilt werden, von minimalem oder keinem Risiko bis zu begrenztem, hohem und inakzeptablem Risiko, also „alle KI-Systeme, die als eindeutige Bedrohung für die Sicherheit, den Lebensunterhalt und die Rechte von Menschen angesehen werden“.

Es folgt dann eine längere Aufzählung dieser Verbote, die sehr allgemein gehalten sind (Hier die Aufzählung des von der Kommission angeboten maschinell übersetzten englischen Textes):

- kritische Infrastrukturen (z. B. Verkehr), die das Leben und die Gesundheit der Bürger gefährden könnten;

- allgemeine oder berufliche Bildung, die den Zugang zu Bildung und beruflichem Verlauf des Lebens einer Person bestimmen kann (z. B. Bewertung von Prüfungen);

- Sicherheitskomponenten von Produkten (z. B. KI-Anwendung in robotergestützter Chirurgie);

- Beschäftigung, Management von Arbeitnehmern und Zugang zu Selbstständigkeit (z. B. CV-Sortierungssoftware für Einstellungsverfahren);

- wesentliche private und öffentliche Dienstleistungen (z. B. Kreditwürdigkeit, bei der den Bürgern die Möglichkeit verweigert wird, ein Darlehen zu erhalten);

- Strafverfolgung, die in die Grundrechte der Menschen eingreifen kann (z. B. Bewertung der Zuverlässigkeit von Beweisen);

- Migrations-, Asyl- und Grenzkontrollmanagement (z. B. Überprüfung der Echtheit der Reisedokumente);

- Rechtspflege und demokratische Prozesse (z. B. Anwendung des Gesetzes auf konkrete Fakten).

Die Hochrisiko-Anwendungen werden dann noch genauer aufs Korn genommen, durch Verpflichtungen, bevor sie auf den Markt gebracht werden können:

- angemessene Risikobewertungs- und Minderungssysteme;

- hohe Qualität der Datensätze, die das System versorgen, um Risiken und diskriminierende Ergebnisse zu minimieren;

- Protokollierung der Tätigkeiten zur Gewährleistung der Rückverfolgbarkeit der Ergebnisse;

- ausführliche Unterlagen, die alle erforderlichen Informationen über das System und seinen Zweck enthalten, damit die Behörden ihre Einhaltung bewerten können;

- klare und angemessene Informationen für den Nutzer;

- angemessene Aufsichtsmaßnahmen zur Minimierung des Risikos;

- ein hohes Maß an Robustheit, Sicherheit und Genauigkeit der Software.

In diesem Zusammenhang ist dann die Rede von „strengen Anforderungen“, „grundsätzlichen Verboten“, „streng definierten und geregelten“ Ausnahmen beispielhaft für die Suche nach vermissten Kindern, bevorstehenden terroristischen Bedrohungen, verdächtigte schwere Straftaten aufzudecken, aufzuspüren, zu identifizieren oder strafrechtlich zu verfolgen. Klingt alles sehr vernünftig, doch der Teufel liegt im Detail, konkret in der nachvollziehbaren Abgrenzung der Tatbestände. Gezielt aufgrund eines Gerichtsbeschlusses die elektronisch aufgezeichneten Kommunikationsspuren einer verdächtigen Person zu verfolgen ist eine Sache. Aber wenn bei der Suche zahlreiche weitere Personen einbezogen werden (müssen), wird es schwierig.

Zum Trost für die vor allem von der Industrie vorgebrachten kritischen Stimmen wird dann konstatiert, dass der bei weitem größte Teil der KI-Anwendungen in die Harmlos-Kategorie fällt und keinen Einschränkungen unterliegt.

Der versuchte Spagat zwischen Innovationsfreundlichkeit und Grundrechtschutz wird dann eher zu suchen sein zwischen ausführlich und erforderlich oder klar und angemessen.

Die davoneilende Technik

Der schnellen Technikentwicklung soll durch ein kontinuierliches Qualitäts- und Risikomanagement durch die Anbieter begegnet werden. Zertifizierte Vorab-Unbedenklichkeits-Bescheinigungen für KI-Anwendungen werden kaum dem Stand der Technik und erst recht nicht ihrem Entwicklungstempo gerecht. Dann bleibt noch eine Art Selbstkontrolle im Rahmen vorgegebener Richtlinien wie Assessments und Folgeabschätzungen.

Das Transparenzgebot für Generative Künstlicher Intelligenz (à la ChatGPT) besagt hauptsächlich die Offenlegung der im Training benutzten Daten. Wie schwierig eine begleitende Qualitätskontrolle ist, lässt sich am Beispiel des Kooperationsvertrages zwischen OpenAI und dem Axel-Springer-Verlag verdeutlichen: Gemäß diesem Deal stellt Springer die digitalisierten Inhalte seiner Medien einschließlich der Bild-Zeitung OpenAI zu Trainingszwecken zur Verfügung und erhält im Gegenzug als qualitätsjournalistisch klassifiziert bezeichnete Zusammenfassungen dieses Daten-Konglomerats - der Axel-Springer-Verlag als neuer Juror für Qualitätsjournalismus.

Was weiß man damit über den Dateninhalt von heute, der sich morgen schon geändert hat – alles das könnte wunderbar funktionieren in einer schönen heilen Welt der grenzenlosen Anständigkeit. Aber auch hier gilt business first, wie aus der Presseerklärung des Axel-Springer-Verlages vom 8.12.2023 hervorgeht. Neben der „Stärkung des Qualitätsjournalismus“ spielt jedoch auch die dort angekündigte automatisierungsbedingte Einsparung von 70 Mitarbeitenden eine wichtige Rolle. Natürlich wird KI keine schlagartigen Massenentlassungen verursachen. Es sind die kleinen Effekte, kontinuierlich auf der Zeit-Schiene. Sie finden keine Erwähnung in dem EU-Regelungsvorschlag.

Googles Chatbot Bard (später umbenannt in Gemini) dagegen warnte seine Benutzer ausdrücklich: "Zur Qualitätssicherung können Prüfer deine Unterhaltungen mit Bard verarbeiten. Gib also bitte keine vertraulichen Daten ein".

Und natürlich das Urheberrecht, der Regulierer liebstes Kind. Um seine Einhaltung zu überprüfen muss alles gescannt werden, noch mehr Kontrolle, noch mehr Schere im Kopf, denn was man so schreibt, könnte ja irgendwer schon einmal geschrieben haben. Auf die Flut von Plagiat-Vorwürfen kann man sich freuen.

Die geplante Verordnung als bloße Schaufensterpolitik abzutun, ist zurzeit nicht gerechtfertigt. Es bleibt abzuwarten, wie die vielen Absichtserklärungen umgesetzt werden.

Und die Zukunft?

Von der konkreten Ausgestaltung der Verordnung wird auch abhängen, was aus dem Versprechen der EU-Kommission wird, administrative und finanzielle Belastungen insbesondere für kleine und mittlere Unternehmen zu verringern. Wenn Vorabprüfungen, Assessments und laufende Qualitätskontrollen in der gewohnten Akribie greifen, wird dies den kleineren Unternehmen den Garaus machen und eine weitere Machtkonzentration der großen Hyperscaler befördern. Eine silicon-Presseerklärung vom 28.12.2023 beschreibt, dass ausgerechnet die großen Tech-Firmen eine schärfere Regulierung befürworten, wohl wissend, dass sie den erhöhten Aufwand gut stemmen können, während die Luft für die kleineren Firmen zunehmend dünner wird:

„Dahinter könnte auch eine Taktik stehen, um neuen Unternehmen in dem Bereich den Einstieg zu erschweren. Die großen Firmen haben in der Regel mehr Ressourcen, um die regulatorischen Anforderungen zu erfüllen (sog. Lobby Capture), und sind damit klar im Vorteil gegenüber Start-ups“

wird ein Informatik-Ingenieur und Patentanwalt in der oben genannten Presseerklärung zitiert.

Auf der Anwenderseite sind viele Unternehmen gerade dabei, erste Erfahrungen mit KI-Projekten zu sammeln. Was die Regulierung für sie bedeutet, ist noch unklar. Vielleicht bekommen im Rahmen abgewandelter Assessment-Verfahren die Ethik-Räte Kinder. Daran können dann auch Betriebsräte beteiligt werden. Sie haben zwar nichts zu sagen, aber sie sind dabei.

| Karl Schmitz, Januar 2024 |